Se llama Bleep y permite silenciar palabras o frases de diferente tipo. Está pensado para chats de videojuegos

El bullying online es uno de los mayores problemas que enfrentan creadores de contenido de videos de todo tipo. Y de hecho en diferentes ámbitos se vienen pidiendo medidas para limitar estas formas de acoso online.

En este contexto, Intel desarrolló un sistema denominado Bleep, que utiliza herramientas de hardware e Inteligencia Artificial (IA) para detectar y filtrar los comentarios tóxicos de otros jugadores durante los chats de voz de las partidas de videojuegos online, con lenguaje violento o discriminatorio.

La compañía hizo una demostración del sistema durante su participación en la conferencia de desarrollo de videojuegos Game Developers Conference (GDC), el 18 de marzo. Se trata de un trabajo que hizo junto con la compañía Spirit AI, especializada en IA.

La herramienta emplea los sistemas de detección de lenguaje tóxico de esa empresa y los combina con las capacidades de los procesadores para acelerar la detección de habla a través de la inteligencia artificial.

Este sistema es capaz de detectar y reducir en los chats de voz de los videojuegos las expresiones tóxicas de los jugadores. Funciona tanto en computadoras portátiles como de mesa con procesadores de Intel.

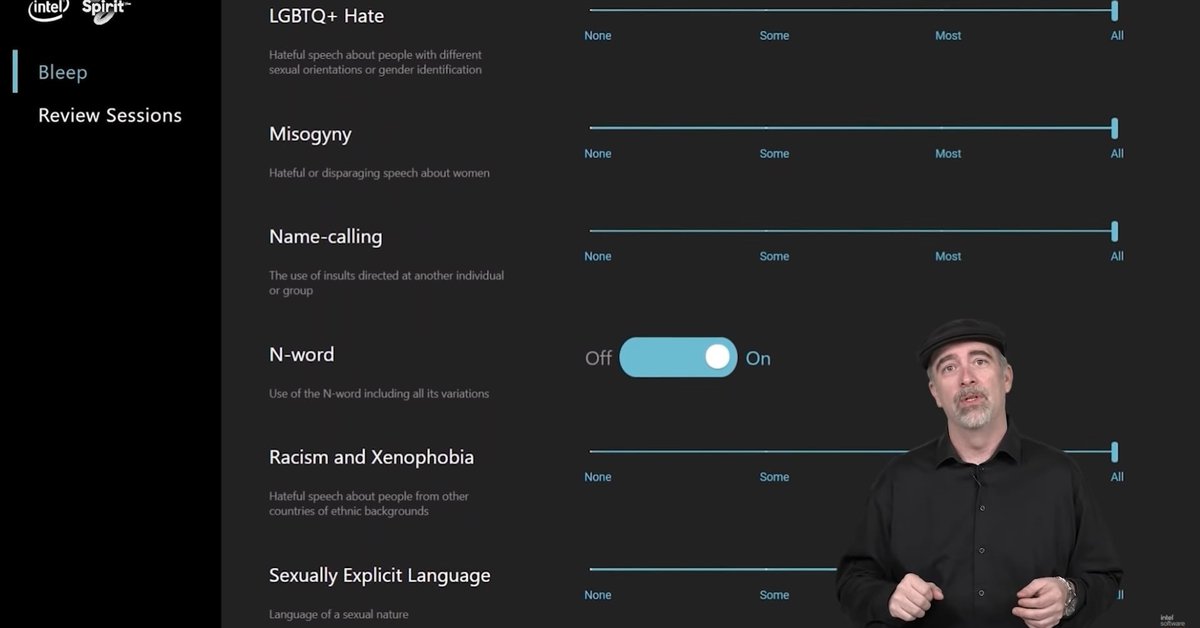

El programa puede configurarse a través de una serie de ajustes, en los que los usuarios pueden elegir los filtros y las categorías a detectar, como los comentarios contra otras personas por discapacidades o por su aspecto físico, el lenguaje agresivo contra otros jugadores, la discriminación a la comunidad LGTBQ+ o la misoginia.

Asimismo, la herramienta también es capaz de advertir otras categorías como el uso de lenguaje racista o xenófobo, sexualmente explícito, insultos o los eslóganes de nacionalismo blanco.

Los ajustes de esta herramienta permiten que, en cada una de las categorías detectadas, los usuarios puedan decidir si prefieren que se filtren “ninguno”, “algunos”, “la mayoría” o “todos” los comentarios inapropiados de los chats de sus partidas.

Actualmente Bleep se encuentra en fase beta, y la empresa espera que su desarrollo esté completo y disponible para los jugadores durante 2021.

No es la única compañía que está buscando soluciones para evitar o detener el acoso online. Todas las redes sociales cuentan con diferentes sistemas para que el usuario pueda reducir el contenido tóxico al que se expone. Esto se puede hacer por medio del establecimiento de filtros o incluso la inhabilitación de comentarios, que se puede hacer, por ejemplo en Instagram. En Twitter también es posible bloquear usuarios o dejar de ver cierto contenido.

Además, todas las plataformas han actualizado en el último tiempo sus políticas de uso con el fin de limitar o al menos reducir ciertos comentarios violentos u ofensivos. A todo esto se suman otras iniciativas como la difundida recientemente por YouTube que plantea ocultar los “no me gusta” con el objetivo de favorecer el bienestar de los creadores.

Infobae